舆情课堂:从信息中破茧而出

信息茧房表现、危害及原因

当你在网上查看信息时,是否会觉得与查询信息相关的内容越来越多,还以为满世界人员都在关注你自己关注的内容,其实不是的,你陷入了信息茧房中。早在2006年,哈佛大学教授凯斯·桑斯坦在其著作《信息乌托邦众人如何生产知识》中提出“信息茧房”概念,认为信息茧房以“个人日报”的形式呈现:伴随着网络技术的发达和信息的剧增,人们可以随意选择想关注的话题,可依据喜好定制报纸、杂志,每个人都可为自己量身打造一份“个人日报”。当个人被禁锢在自我建构的信息环境中,生活必然变得程序化、定式化。

桑斯坦指出,在信息传播中,因公众自身的信息需求并非全方位的,公众只注意自己选择的东西和使自己愉悦的通讯领域,久而久之,会将自身桎梏于像蚕居一般的“茧房”中。

基于个人兴趣或者喜好定制的报纸或者杂志,会每天给予对应的信息接收者一份日报,这份日报上面呈现的内容虽然是不一样的,但是其信息类别是一致的,这为网络信息茧房的形成创造了条件。如某聚合类客户端会结合用户的浏览习惯和内容,继而推送与用户兴趣相关的信息,久而久之每个人打开的该APP呈现内容都不一样,但是相对于个体而言,其关注领域还是处于“个人日报”的状态。

信息茧房危害主要表现在网络群体极化趋势会不断加强。人们看到越来越多的是和自己意见相同的内容,认为这就是真实的状况,并强化个人的认知。信息茧房还会降低人们之间的交流和沟通,造成群体粘合度的下降。信息极化过程中强化对个人观点正确性的作用,对于不同意见更难以接受,在网络和真实空间中对立更严重。信息茧房形成过程中,推荐算法起了非常关键作用。因此需要对推荐算法做一个相对全面、深入的介绍。

推荐算法介绍

推荐算法类别

推荐算法通常被分为五大类,再加上高级非传统方法,形成5+1结构。包括协同过滤推荐算法,基于内容的推荐算法,混合推荐算法,流行度推荐算法,关联规则推荐算法和高级非传统的推荐算法1。目前推荐算法中,使用广、效果好的为协同过滤推荐算法。

协同过滤推荐算法

协同过滤定义:通过在用户的一系列行为中寻找特定模式来产生用户个性化特殊推荐。仅仅依赖于惯用数据(例如评价、购买、下载等用户偏好行为)作为输入来源。类型有两种,一种是基于邻域/内存的协同过滤(基于用户和基于项),是一种统计方法。一种是基于模型的协同过滤(矩阵因子分解、受限玻尔兹曼机、贝叶斯网络等等)。

基于邻域/内存的推荐算法

从主体的不同设定分为两种。

(1)基于用户的协同过滤推荐算法

该算法以用户为中心,借助于用户与项目之间的交互寻找与该用户相似的用户群,这种算法的核心就是相似性计算方法,得到信任用户才能进一步得到推荐结果。

(2)基于项目的协同过滤推荐算法

同上一个算法相反,它从项目的角度出发,通过不同用户在与同一项目的交互中计算出项目的相似性。而且就表面来看和基于内容的推荐算法有些相似,但仔细研究就会发现基于内容的算法是根据项目标签来计算相似度,而基于项目的算法本质还是协同过滤,数据源是用户项目间的交互数据。

从两种不同主体出发获得用于计算数据完全不同,因此二者进行相似度计算时(如利用余弦夹角计算),得出的相似度是不一样的,对应的推荐结果也是不同的,值得注意。

基于模型的推荐算法

基于模型的推荐算法用部分已有的稀疏数据来预测空白交互,并对这个过程进行数学建模得到预测模型。

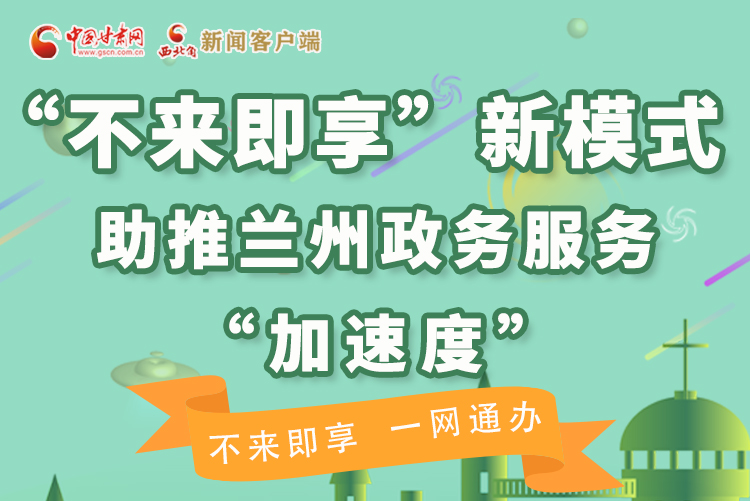

举例而言,一个用户看电视节目有偏好,对TA的行为进行0~5分的评分。针对一个特定的节目,如果直接选择不喜欢或者拉黑了,得0分;打开了但是30秒内就关掉,得1分;看了0.5~2分钟,得2分;看了2~15分钟或以上但没有看完,得3分;看完了得4分,看完了并且保存或者推荐给其他用户,得5分。根据以上规则,可以把所有用户和所有的节目构造成一张巨大的表,叫做U—i 矩阵,见表格 1。

表格1

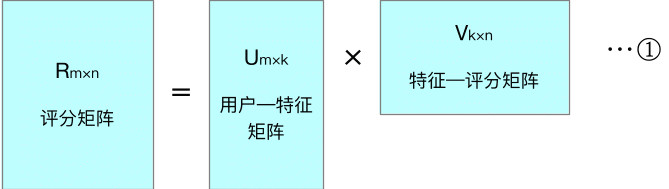

以上的用户-项目评分矩阵是非常稀疏的,毕竟一个人看的一个电视台(如央视)的节目是非常有限的,表格中基本上只有0.1%的单元格有数据。如果我们能通过预测把上述表格填满,这样就可以实现对用户的推荐了。填满上表有两种方式,一种是直接估计空格的值,一种是对评分矩阵通过矩阵分解来填满空格。矩阵分解方法中,LFM(Latent factor model)隐/潜语义模型是目前使用最多,并且效果很好的一种方法。

隐/潜语义模型(LFM)实现推荐过程

LFM实现推荐原理

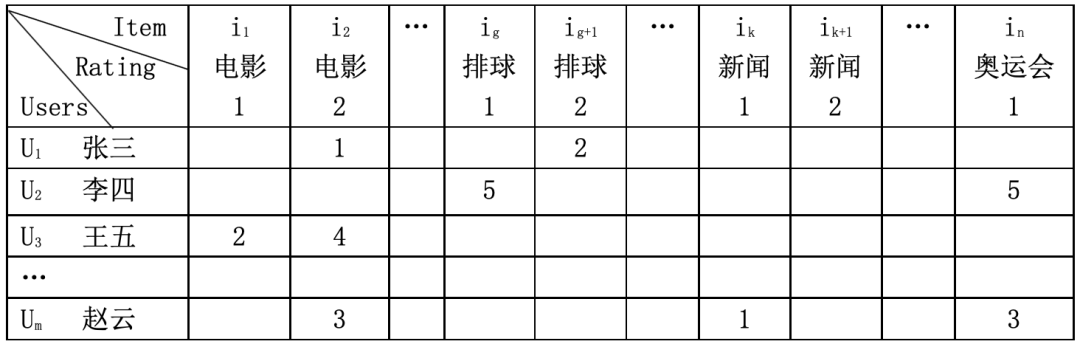

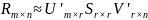

LFM采取基于特征推荐算法,即对视频的兴趣进行分类。针对于一个用户,最先得到他的兴趣分类,再从兴趣分类中找到他可能会喜欢的视频。LFM直接从数据出发,自动找到那些隐类,也就是所谓的潜在因子,并进行个性化推荐。见图1 LFM实现原理。

图1LFM实现原理

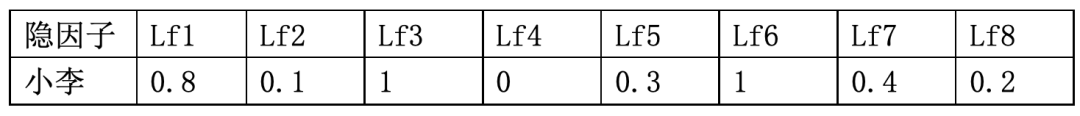

对于以上内容举一个例子。用户小李被LFM模型自动识别其观看节目的潜在因子。见下表。

此处需注意,隐因子不是喜剧、动作、科幻、爱情、悬疑、恐怖、剧情、冒险等可以辨识的标签,而是模型自动分辨出的,比如Lf3有可能是色彩艳丽,Lf6有可能是表示英格丽·褒曼等,但是这些隐因子究竟是什么,许多时候也是不好解释的,这也是这种方法受到诟病的一个方面。

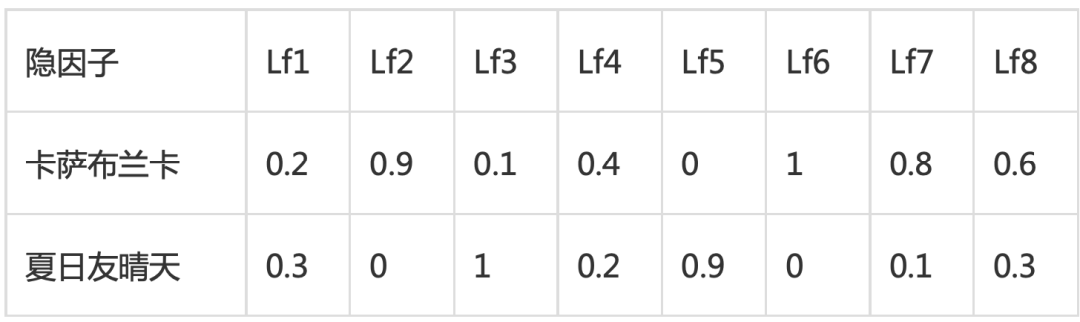

假设现在有两部电影,LFM模型自动识别其包含隐因子的程度如下:

表格3 电影中含有的隐因子(隐类)的比重

现在可以计算小李和卡萨布兰卡的匹配程度:

0.8*0.2+0.1*0.9+0.5*0.1+0*0.4+0.3*0+1*1+0.4*0.8+0.2*0.6=1.79,

小李和夏日友晴天的匹配程度:

0.8*0.3+0.1*0+0.5*0.7+0*0.2+0.3*0.9+1*0+0.4*0.1+0.2*0.3=1.61

于是,《卡萨布兰卡》比《夏日友晴天》更适合小李。上述过程是通过矩阵分解方式实现的。

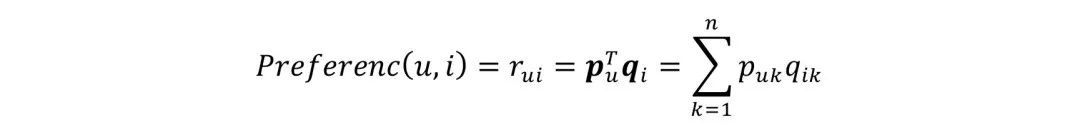

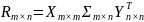

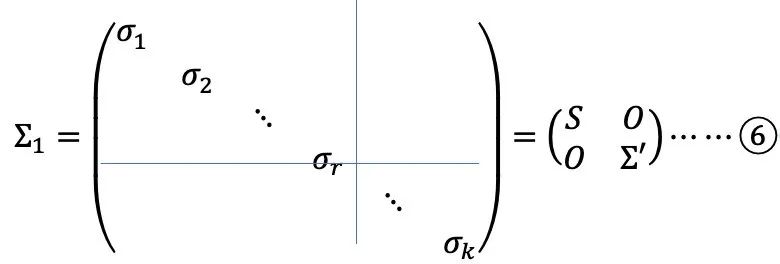

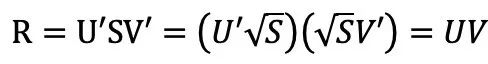

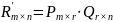

上述过程形式化表达如下2:

矩阵奇异值分解方法

在公式①中,表格2是矩阵V中一列,表格3是矩阵U中一行。通过评分矩阵R怎样得到U和V?这就需要专业的矩阵分解方法实现。

矩阵的奇异值分解实现功能理解

对矩阵R进行奇异值分解(SVD)

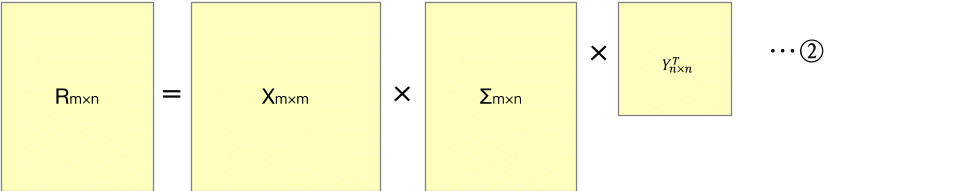

看到②和①是不一样的,②多了Σ这个矩阵,而且X和Y还是方阵。其中,

对角线元素

(i=1,2, … ,k), 且σ

1≥σ2≥?≥σk>0.??为RTR的特征值。通过压缩形式奇异值分解得到:

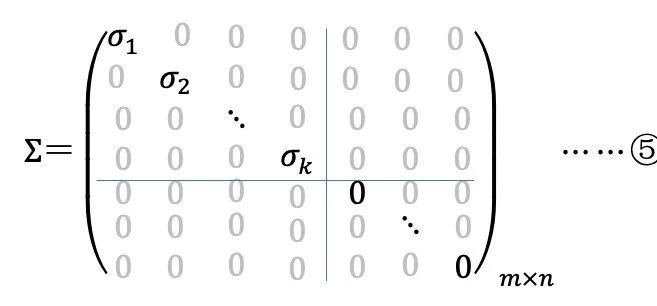

∑1为⑤中分块矩阵左上角那一块,是一个对角方阵,主对角线元素都大于0,且按降序排列。于是可以得到如下所示压缩形势对奇异值分解3。

∑1中奇异值σ的减少特别快,在很多情况下,前10%甚至1%奇异值的和就占了全部奇异值之和99%以上了。也就是说,可以用前r 个奇异值来近似描述矩阵。⑤式中表示潜在因子的矩阵维度k还是太大了,需要降维再简化,找到一个r?k,但是又最大限度地保留了R信息。通过矩阵分块,可以近似地找到一个简化矩阵,即对角矩阵S,见公式⑥

⑥保留其r个最大奇异值的左奇异矩阵组成一个r 维空间(r×n) ,于是得到一个新的对角矩阵Sr×r,有

奇异值分解能够产生初始矩阵R 的所有秩等于r 的矩阵中,与矩阵R 最近似的一个

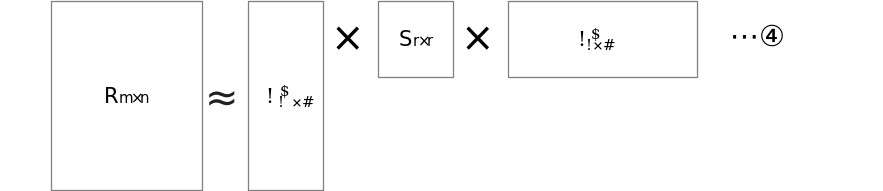

2006年,隐语义模型首先由Simon Funk 在博客上公布,后来被Netflix Prize的冠军Koren 称为Latent Factor Model 即LFM。它在 SVD分解的基础上,将中间的奇异矩阵分解并(hua)合(zhong)并(dian)到左右奇异矩阵中,这个过程如下:

到了这样才回到了公式①的形状。这一点是许多人都不知道的。

在降低维度的同时尽可能保持原有数据的信息,然后基于该低阶近似矩阵进行协同过滤推荐,提高了推荐算法的可扩展性,同时还可以得到用户和项目之间潜在的关联。

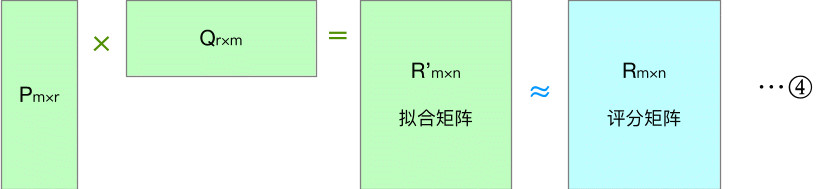

实现路线

求取用户-特征矩阵P和特征-项目矩阵Q。让P×Q可以得到稠密的拟合矩阵,拟合矩阵R’约等于评分矩阵R,就完成了分类和推荐。

求取方法有两种,一种是利用线性代数方法根据奇异值分解理论求解。另外一种是利用机器学习方法训练出拟合矩阵的两个稠密矩阵P和Q。

线性代数方法分解矩阵

由于R非常稀疏,不易分解。首先需要要补全用户——项目这个评分矩阵R。可以用一些简单方法补全稀疏评分矩阵。而一旦补全,评分矩阵就会变为一个稠密矩阵,从而让R的存储需要非常大的的空间,这种空间需求在实际系统中是不可接受的。

矩阵分解计算复杂度太高。系统在稠密的大规模矩阵中运算非常慢。一般来说,这里的SVD 分解用于1000维以上的矩阵就已经非常慢了,而实际系统动辄就是上千万的用户和上百万的物品,所以这一方法在实际中基本上无法使用。况且补全矩阵R时采用的方法如果出现偏差会对结果造成很大影响。SVD分解方法还容易出现过拟合现象。所有这些都说明SVD方法在大数据量中是不合适的。

利用机器学习方法得到P和Q

采用机器学习的方法通过迭代拟合原始数据,可以有效降低计算代价并获得良好的训练结果。篇幅所限,本文先不展开相关论述。基本原理即以评分矩阵R中已有数据单元格(含打分为0的项)值和对应的拟合矩阵R’相应位置值的均方误为损失函数,加入适当的正则项减少结构风险构成风险函数,然后让风险函数最小化,得到相应的参数。

由于

实际上是对P和Q两个矩阵进行训练。采用均值为0,方差为1的高斯分布数据来初始化矩阵P和Q4。利用梯度下降法训练P和Q中的分量(参数),构建需要的模型。

信息茧房治理举措

技术方法减轻正反馈

用算法减轻信息茧房影响。算法推荐内容用户看后,形成一个相似内容自我加强的正反馈环,必须破解这个正反馈。如TS—ICC算法在缓和推荐结果对个人知识的狭隘和信息结构的不平衡上有着积极作用5。在推荐算法设计中,一定要加入随机扰动因子等,这样在一定程度上可以避免不断地自我强化隐患。还可增加信息偶遇机会来达成“破茧”目标。平台应无差别推荐一些多领域内容,利用大数据人工智能算法与内容分发的平衡状态,对信息茧房进行矫治以最大程度地实现个人价值和公共价值。有关部门可考虑要求平台企业使用的推荐算法中,加入缓和信息茧房的算法进行某种程度的对冲。

规则引领与优化

2021年11月1日施行的《中华人民共和国个人信息保护法》规定,个人信息处理者通过自动化决策方式向个人进行信息推送、商业营销,应当同时提供不针对其个人特征的选项,或者向个人提供便捷的拒绝方式。让算法走向规范化是整个社会的责任。以外卖骑手路线优化为例,法律、法规、监管政策明确要求算法优化路线中需要关照人文的诉求。通过系列组合拳合理限制和防止信息滥用,有助于避免算法推荐“野蛮生长”,从而平衡个人便利性、信息获取多样性、以人为本等多重目标。

平台和社会、公众良性互动

互联网平台应积极响应社会关切和法律规范,优化改善现有算法以提升用户体验,寻找一种更透明、更可持续的发展道路,并付诸实施。例如,告诉公众在算法推荐时应用了哪些方法,回应公众质疑并良性互动,让受众可以更加真实地了解信息社会。

个人保持独立思考

要从信息茧房中破茧而出,网民也应注意不要给自己贴标签,不要盲目地跟随别人的意见和建议。要相信个人看到的不是这个世界全面真实的情况。对于频繁出现的相同/近似推荐内容,不妨试试选择APP提供的“减少同类推荐”选项。多选择一些其他内容观看,多进行一些线下交流,可以拓展眼界,从个体角度警惕身陷“算法泡沫”,共同提升网络素养与数字文明程度。

- 2022-04-11舆情课堂:政务公开新形势与政务新媒体发展建议

- 2022-04-06舆情课堂:事实核查对舆情分析工作的启示

- 2022-03-28舆情课堂:解剖乡镇干部形象危机

- 2022-03-08舆情课堂:政务新媒体要克制“蹭热点”式的借势营销

西北角

西北角 中国甘肃网微信

中国甘肃网微信 微博甘肃

微博甘肃 学习强国

学习强国 今日头条号

今日头条号